Los robots militares tienen el dedo en el gatillo y tendrán que tomar decisiones para usar fuerza letal, hay argumentos prácticos y éticos a favor y en contra

Metalhead, un angustioso episodio de Black Mirror, muestra un mundo apocalíptico en que solo quedan un puñado de personas, y en el que unos imperturbables perros robot (basados en el modelo Spot fabricado por Boston Dynamics) persiguen a los pocos supervivientes para matarlos, sin nada ni nadie que los controle.

Hoy en día, la mayoría de las armas con tecnología de inteligencia artificial son las llamadas semiautónomas, que permiten pasar de una programación automática a modo manual, para que sea un humano el que tome la decisión final de apretar el gatillo.

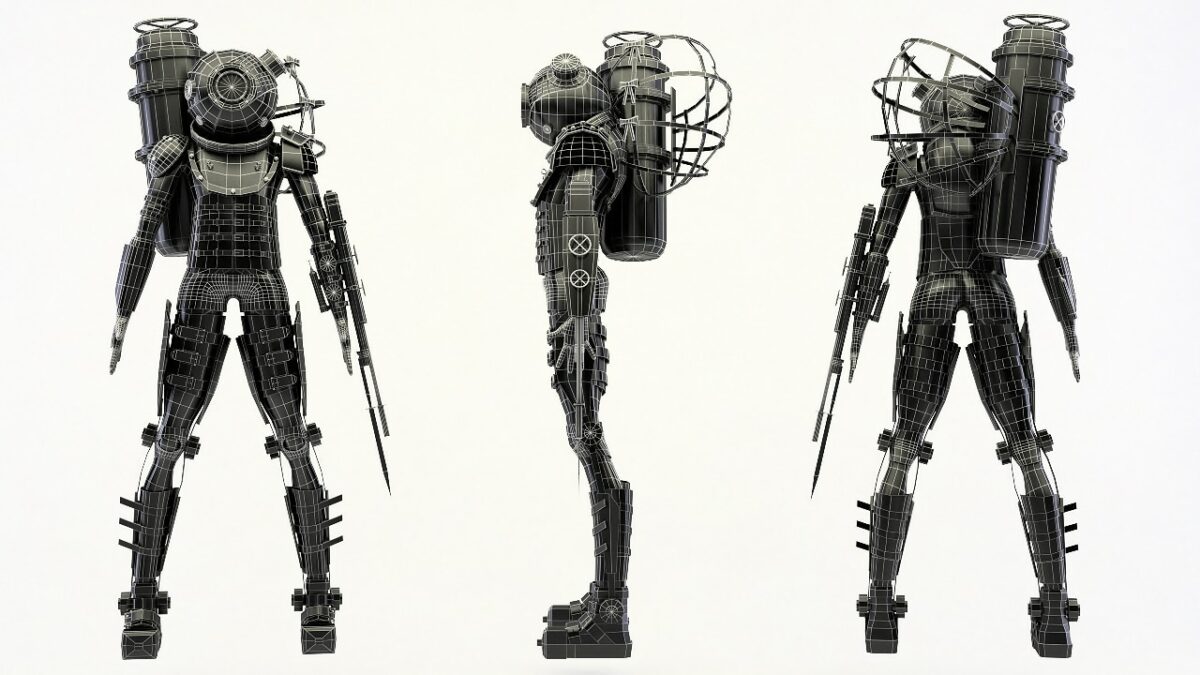

Sin embargo, muchos países desarrollan máquinas autónomas cada vez más sofisticadas con tecnología que les permitiría seleccionar objetivos y disparar sin intervención humana. El debate entre los expertos es si estas armas o robots autónomos serían mejores soldados que los humanos, más precisos y ecuánimes, y por tanto, si se permiten y se regulan, o si se prohíbe su uso.

Los robots no sienten emociones

Algunos expertos, como Noel Sharkey, profesor emérito de inteligencia artificial y robótica en la Universidad de Sheffield, advierten de que las armas autónomas serían difíciles de predecir y controlar. Además, podrían programarse para cumplir órdenes ilegales y éticamente reprochables, ya que carecen de emociones o sentido de la moral. Delegar las decisiones de guerra en manos de máquinas podría llevar a que los conflictos se descontrolaran rápidamente. Por eso, insiste en que siempre se usen bajo supervisión humana.

Estas preocupaciones llevaron a crear en 2013 una Campaña para Detener a los Robots Asesinos, organizada por una coalición de 112 ONG y 56 países e impulsada por grupos de expertos en robótica e inteligencia artificial, figuras del sector tecnológico y grupos de defensa de los derechos humanos, liderados por Human Rights Watch.

Esta iniciativa se consolidó en 2020 con un informe con la respuesta de noventa y siete países sobre la prohibición de las armas autónomas, con el acuerdo de que “mantener un control humano significativo sobre el uso de la fuerza es un imperativo ético, una necesidad legal y una obligación moral”.

El secretario general de la ONU, Antonio Guterres, señala que muchos países están de acuerdo en regular el uso de armas autónomas, legislando o tomando medidas políticas, pero lo cierto es que países como Gran Bretaña, Estados Unidos, Corea del Sur, China e Israel siguen invirtiendo en este tipo de tecnologías. Además, siempre habría que confiar en que los países firmantes cumplieran el pacto.

Los robots soldado son más precisos y selectivos

Missy Cummings, una de las primeras mujeres piloto de caza de la Marina de Estados Unidos y actualmente directora del Laboratorio de Humanos y Autonomía (HAL) de la Universidad de Duke, desarrolla sistemas informáticos de colaboración entre computadoras y humanos.

En el campo militar, Cummings investiga cómo la tecnología ha cambiado la forma en que los humanos se relacionan con sus armas. Por una parte, cree que el desarrollo tecnológico nos distancia emocionalmente del acto de matar, como ocurre con los soldados que pueden asesinar a alguien con un dron controlado remotamente. Pero por otro lado nos permite crear armas más precisas y más selectivas. Cummings considera que el factor humano lleva a errores que la tecnología minimiza.

“Conozco a gente que ha matado a civiles o a aliados. Han lanzado bombas sobre sus propias tropas, matando a sus soldados. Sencillamente, era demasiada información, las cosas estaban pasando demasiado rápido”.

Ash Carter, físico y ex secretario de Defensa de Estados Unidos, defiende el uso de ciertas armas autónomas, como los enjambres de drones, que pueden confundir y abrumar a sensores enemigos o llevar a cabo misiones de rescate. Cree que el futuro de los robots soldado autónomos pasa por realizar misiones muy peligrosas que no le gustaría que hicieran soldados de carne y hueso “si los puedo reemplazar por un robot”.

Robots más éticos

El experto en roboética y director del Laboratorio Móvil Robot, Ronald C. Arkin, va un poco más allá. Aunque se declara en contra de las armas letales y de las guerras, considera que es mejor usar robots. La ciencia puede y debe enfocarse en mejorar la defensa de los civiles, y además una tecnología bien diseñada a nivel operativo y ético podría salvar vidas, requerir menos tropas y reducir los crímenes de guerra.

Arkin argumenta que los sistemas autónomos no serán perfectamente éticos en el campo de batalla, pero “estoy convencido de que pueden actuar de manera más ética que los soldados”. Los robots no tienen emociones, pero tampoco sienten miedo, angustia, rabia, o deseos de venganza que nublen su juicio.

REFERENCIAS

CCW Informal Experts Meeting on LAWS May 2014

Campaign to Stop Killer Robots

Noticias ONU – El ser humano ha de retener la capacidad de control sobre las armas autónomas

Podcast Brave New Planet – Robots and the Future of War

U.S. Department of Defense – Biography Ashton B. Carter

Lethal Autonomous Weapons Systems and the Plight of the Noncombatant