A finales de la semana pasada, OpenAI anunció un nuevo sistema de IA generativa llamado Sora, que produce vídeos cortos a partir de mensajes de texto. Aunque Sora aún no está a disposición del público, la alta calidad de los vídeos de muestra publicados hasta ahora ha suscitado reacciones tanto de entusiasmo como de preocupación.

Los vídeos de muestra publicados por OpenAI, que según la empresa han sido creados directamente por Sora sin modificaciones, muestran resultados a partir de mensajes como «un primer plano fotorrealista de dos barcos piratas luchando entre sí mientras navegan dentro de una taza de café» e «imágenes históricas de California durante la fiebre del oro».

A primera vista, suele ser difícil decir que han sido generados por IA, debido a la gran calidad de los vídeos, las texturas, la dinámica de las escenas, los movimientos de cámara y un buen nivel de coherencia.

El director ejecutivo de OpenAI, Sam Altman, también publicó en X (antes Twitter) algunos vídeos generados en respuesta a sugerencias de los usuarios, para demostrar las capacidades de Sora.

¿Cómo funciona Sora?

Sora combina características de herramientas de generación de texto e imágenes en lo que se denomina un «modelo de transformador de difusión».

https://t.co/rmk9zI0oqO pic.twitter.com/WanFKOzdIw

— Sam Altman (@sama) February 15, 2024

Los transformadores son un tipo de red neuronal introducida por primera vez por Google en 2017. Son más conocidos por su uso en grandes modelos lingüísticos como ChatGPT y Google Gemini.

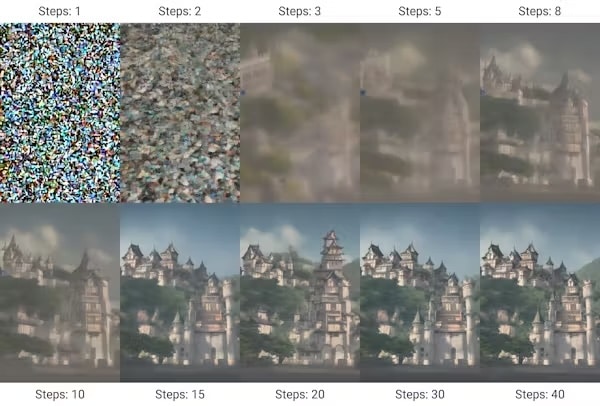

Los modelos de difusión, por otro lado, son la base de muchos generadores de imágenes de IA. Funcionan comenzando con ruido aleatorio e iterando hacia una imagen «limpia» que se ajuste a una solicitud de entrada.

Los modelos de difusión (en este caso Stable Diffusion) generan imágenes a partir de ruido mediante muchas iteraciones. (Stable Diffusion/Benlisquare/Wikimedia, CC BY-SA)

Se puede crear un vídeo a partir de una secuencia de imágenes de este tipo. Sin embargo, en un vídeo, la coherencia y la consistencia entre fotogramas son esenciales.

Sora utiliza la arquitectura de transformadores para gestionar cómo se relacionan los fotogramas entre sí. Mientras que los transformadores se diseñaron inicialmente para encontrar patrones en tokens que representan texto, Sora utiliza tokens que representan pequeños fragmentos de espacio y tiempo.

A la cabeza pero con errores

Sora no es el primer modelo de conversión de texto en vídeo. Modelos anteriores son Emu de Meta, Gen-2 de Runway, Stable Video Diffusion de Stability AI y, recientemente, Lumiere de Google.

Lumiere, que salió a la venta hace apenas unas semanas, afirmaba producir mejores vídeos que sus predecesores. Pero Sora parece ser más potente que Lumiere al menos en algunos aspectos.

Sora puede generar vídeos con una resolución de hasta 1920 × 1080 píxeles, y en diversas relaciones de aspecto, mientras que Lumiere se limita a 512 × 512 píxeles. Los vídeos de Lumiere duran unos 5 segundos, mientras que Sora hace vídeos de hasta 60 segundos.

Lumiere no puede hacer vídeos compuestos de varias tomas, mientras que Sora sí. Según los informes, Sora, al igual que otros modelos, también es capaz de realizar tareas de edición de vídeo, como crear vídeos a partir de imágenes u otros vídeos, combinar elementos de distintos vídeos y extender vídeos en el tiempo.

Ambos modelos generan vídeos ampliamente realistas, pero pueden sufrir alucinaciones. Los vídeos de Lumiere pueden reconocerse más fácilmente como generados por IA. Los vídeos de Sora parecen más dinámicos, con más interacciones entre elementos.

Sin embargo, en muchos de los vídeos de ejemplo las incoherencias se hacen evidentes al examinarlos de cerca.

Aplicaciones prometedoras

En la actualidad, los contenidos de vídeo se producen filmando el mundo real o utilizando efectos especiales, lo que puede resultar costoso y llevar mucho tiempo. Si Sora llega a estar disponible a un precio razonable, la gente podría empezar a utilizarlo como software de creación de prototipos para visualizar ideas a un coste mucho menor.

Por lo que sabemos de las capacidades de Sora, podría incluso utilizarse para crear vídeos cortos para algunas aplicaciones de entretenimiento, publicidad y educación.

El documento técnico de OpenAI sobre Sora se titula «Video generation models as world simulators». El documento sostiene que las versiones más grandes de generadores de vídeo como Sora pueden ser «simuladores capaces del mundo físico y digital, y de los objetos, animales y personas que viven en ellos».

«a giant cathedral is completely filled with cats. there are cats everywhere you look. a man enters the cathedral and bows before the giant cat king sitting on a throne.»

Video generated by Sora. pic.twitter.com/bkNqCnckUo

— Bill Peebles (@billpeeb) February 17, 2024

Si esto es cierto, las futuras versiones podrían tener aplicaciones científicas para experimentos físicos, químicos e incluso sociales. Por ejemplo, se podría probar el impacto de tsunamis de distintos tamaños en diferentes tipos de infraestructuras, y en la salud física y mental de las personas cercanas.

Alcanzar este nivel de simulación es todo un reto, y algunos expertos afirman que un sistema como Sora es fundamentalmente incapaz de hacerlo.

Un simulador completo tendría que calcular las reacciones físicas y químicas en los niveles más detallados del universo. Sin embargo, simular una aproximación del mundo y hacer vídeos realistas a ojos humanos podría estar al alcance de la mano en los próximos años.

Riesgos y preocupaciones éticas

Las principales preocupaciones en torno a herramientas como Sora giran en torno a su impacto social y ético. En un mundo ya plagado de desinformación, herramientas como Sora pueden empeorar las cosas.

Es fácil ver cómo la capacidad de generar vídeos realistas de cualquier escena que se pueda describir podría utilizarse para difundir noticias falsas convincentes o arrojar dudas sobre imágenes reales. Podría poner en peligro las medidas de salud pública, utilizarse para influir en las elecciones o incluso sobrecargar el sistema judicial con posibles pruebas falsas.

Los generadores de vídeo también pueden permitir amenazas directas a personas concretas, a través de deepfakes, especialmente pornográficos. Esto puede tener terribles repercusiones en la vida de las personas afectadas y sus familias.

Más allá de estas preocupaciones, también hay cuestiones de derechos de autor y propiedad intelectual. Las herramientas de IA generativa requieren grandes cantidades de datos para su entrenamiento, y OpenAI no ha revelado de dónde proceden los datos de entrenamiento de Sora.

Los grandes modelos lingüísticos y los generadores de imágenes también han sido criticados por este motivo. En Estados Unidos, un grupo de autores famosos ha demandado a OpenAI por un posible uso indebido de sus materiales. El caso argumenta que los grandes modelos lingüísticos y las empresas que los utilizan están robando el trabajo de los autores para crear nuevos contenidos.

No es la primera vez en los últimos tiempos que la tecnología va por delante de la ley. Por ejemplo, la cuestión de las obligaciones de las plataformas de medios sociales a la hora de moderar contenidos ha suscitado un acalorado debate en los dos últimos años, en gran parte en torno a la Sección 230 del Código estadounidense.

Aunque estas preocupaciones son reales, la experiencia nos dice que no frenarán el desarrollo de la tecnología de generación de vídeo.

OpenAI afirma que está «tomando varias medidas de seguridad importantes» antes de poner Sora a disposición del público, entre ellas trabajar con expertos en «desinformación, incitación al odio y sesgo» y «crear herramientas para ayudar a detectar contenido engañoso».