El chatbot ChatGPT obtuvo mejores resultados que los médicos en formación a la hora de evaluar casos complejos de enfermedades respiratorias

Las enfermedades donde ChatGPT superó a los médicos residentes fueron la fibrosis quística, el asma y las infecciones torácicas. Los resultados se hicieron públicos en un estudio presentado en el Congreso de la Sociedad Respiratoria Europea (ERS) celebrado en Viena.

El estudio también demostró que el chatbot Bard de Google rindió mejor que los residentes en algunos aspectos y que el chatbot Bing de Microsoft rindió igual de bien qe los residentes.

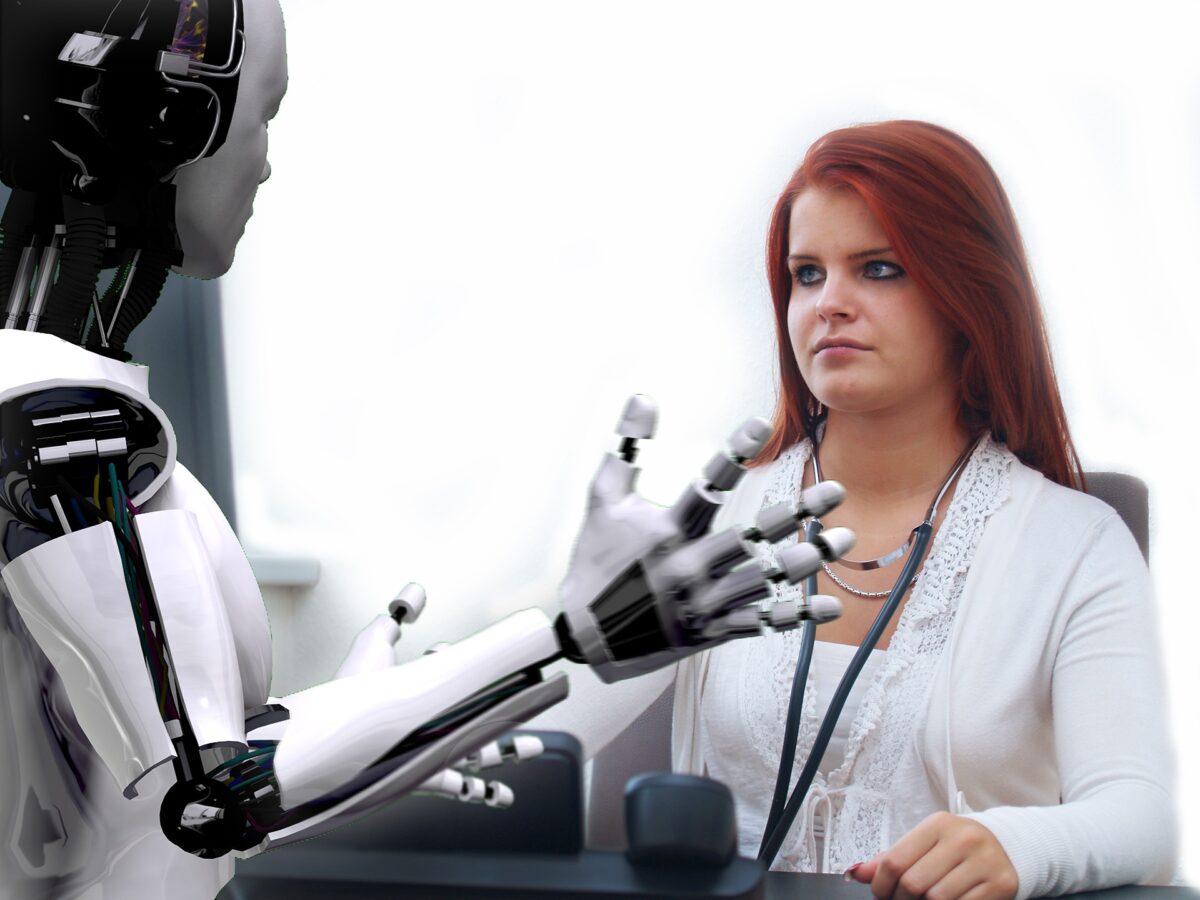

La investigación sugiere que estos grandes modelos lingüísticos (LLM) podrían utilizarse para ayudar a médicos en prácticas, enfermeros y médicos generalistas a clasificar a los pacientes más rápidamente y aliviar la presión sobre los servicios sanitarios.

El estudio fue presentado por el Dr. Manjith Narayanan, especialista en neumología pediátrica del Royal Hospital for Children and Young People de Edimburgo y profesor clínico honorario de la Universidad de Edimburgo (Reino Unido). Según sus palabras: «Los grandes modelos lingüísticos, como ChatGPT, han cobrado protagonismo en el último año y medio por su capacidad para comprender aparentemente el lenguaje natural y ofrecer respuestas que pueden simular adecuadamente una conversación de tipo humano. Estas herramientas tienen varias aplicaciones potenciales en medicina. Mi motivación para llevar a cabo esta investigación era evaluar hasta qué punto los LLM son capaces de ayudar a los médicos en la vida real».

Para investigarlo, la Dra. Narayanan utilizó escenarios clínicos que se dan con frecuencia en medicina respiratoria pediátrica. Los escenarios fueron proporcionados por otros seis expertos en medicina respiratoria pediátrica y abarcaban temas como la fibrosis quística, el asma, los trastornos respiratorios del sueño, la disnea y las infecciones torácicas. Se trataba de situaciones en las que no hay un diagnóstico obvio y en las que no existen pruebas publicadas, directrices o consenso de expertos que apunten a un diagnóstico o plan específico.

Médicos residentes contra chatbots

Diez médicos residentes con menos de cuatro meses de experiencia clínica en pediatría dispusieron de una hora en la que podían utilizar Internet, pero no ningún chatbot, para resolver cada escenario con una respuesta descriptiva de 200 a 400 palabras. Cada escenario se presentó también a los tres chatbots.

Seis expertos en neumología pediátrica puntuaron todas las respuestas en función de su corrección, exhaustividad, utilidad, verosimilitud y coherencia. También se les pidió que dijeran si pensaban que cada respuesta había sido generada por un humano o por un chatbot y que dieran a cada respuesta una puntuación global sobre nueve.

Las soluciones proporcionadas por la versión 3.5 de ChatGPT obtuvieron una puntuación media de siete sobre nueve y se consideraron más humanas que las respuestas de los demás chatbots. Bard obtuvo una puntuación media de seis sobre nueve y fue calificado como más «coherente» que los médicos en prácticas, pero en otros aspectos no fue ni mejor ni peor que los médicos en prácticas. Bing obtuvo una puntuación media de cuatro sobre nueve, la misma que los médicos en formación. Los expertos identificaron con fiabilidad las respuestas de Bing y Bard como no humanas.

Según la Dra. Narayanan: «Nuestro estudio es el primero, que sepamos, en poner a prueba a estudiantes de máster contra médicos en prácticas en situaciones que reflejan la práctica clínica real. Para ello, permitimos a los médicos en formación tener pleno acceso a los recursos disponibles en Internet, como harían en la vida real. De este modo, no nos centramos en evaluar la memoria, donde los LLM tienen una clara ventaja. Por lo tanto, este estudio nos muestra otra forma en la que podríamos estar utilizando los LLM y lo cerca que estamos de la aplicación clínica habitual del día a día».

«No hemos probado directamente cómo funcionarían los LLM en funciones de cara al paciente. Sin embargo, podrían ser utilizados por enfermeras de triaje, médicos en formación y médicos de atención primaria, que a menudo son los primeros en revisar a un paciente».

Los investigadores no encontraron ningún caso evidente de «alucinaciones» (información aparentemente inventada) con ninguno de los tres LLM. «Aunque en nuestro estudio no observamos ningún caso de alucinación por parte de los LLM, debemos ser conscientes de esta posibilidad y adoptar medidas de mitigación», añadió la Dra. Narayanan. En ocasiones, Bing, Bard y los médicos en prácticas dieron respuestas que se consideraron irrelevantes para el contexto.

El Dr. Narayanan y sus colegas planean ahora poner a prueba los chatbots con médicos más veteranos y con médicos en prácticas más recientes y avanzados.

Sin embargo, como señalan los investigadores, antes de empezar a utilizar la IA en la práctica clínica rutinaria, tenemos que estar seguros de que no creará errores, ya sea por «alucinar» información falsa o porque se haya entrenado con datos que no representan equitativamente a la población atendida.

Como han demostrado los investigadores, la IA encierra la promesa de una nueva forma de trabajar, pero necesitamos pruebas exhaustivas de precisión y seguridad clínicas, una evaluación pragmática de la eficiencia organizativa y la exploración de las implicaciones sociales antes de incorporar esta tecnología a la atención rutinaria.

REFERENCIA