Investigadores de Columbia Engineering utilizan IA para enseñar a los robots a que reaccionen a los gestos de los humanos. Si le sonríes, te sonríe. Si te enfadas, se enfada.

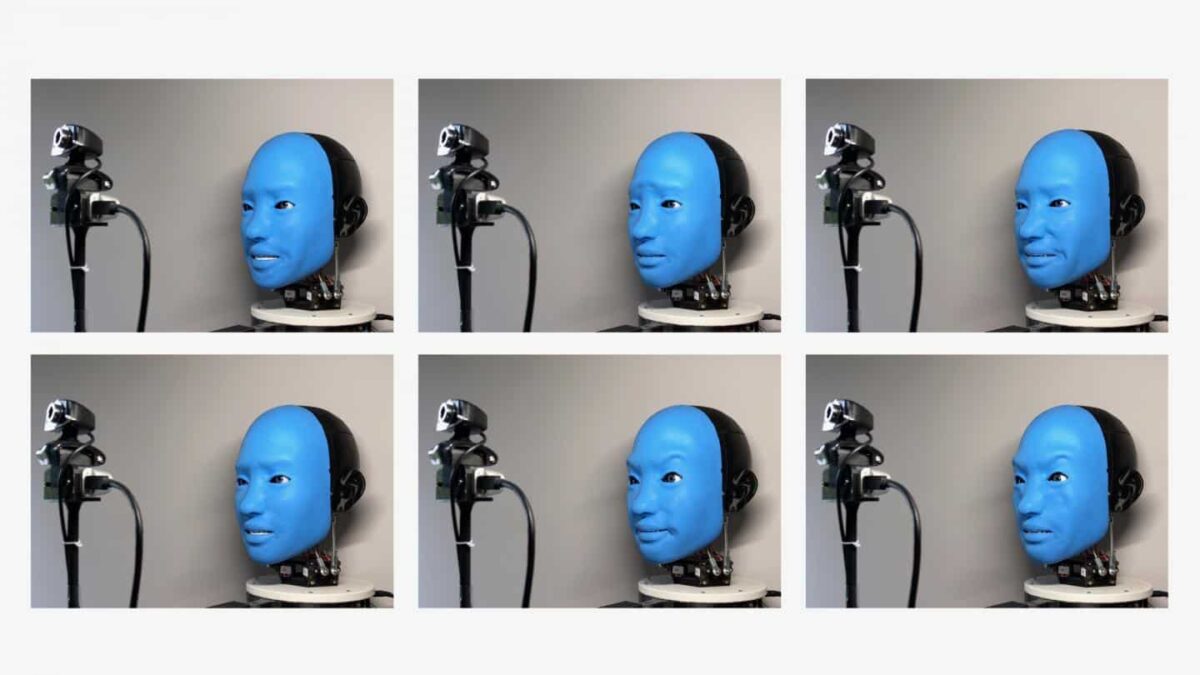

EVA puede expresar las seis emociones básicas de ira, asco, miedo, alegría, tristeza y sorpresa, así como una serie de emociones más matizadas, mediante el uso de «músculos» artificiales (es decir, cables y motores) que tiran de puntos específicos de la cara de EVA, imitando los movimientos de los más de 42 músculos diminutos unidos en varios puntos a la piel y los huesos de los rostros humanos.

Aunque nuestras expresiones faciales desempeñan un papel muy importante a la hora de generar confianza, la mayoría de los robots siguen mostrando el rostro inexpresivo y estático de un jugador de póquer profesional.

Con el creciente uso de robots en lugares donde deben colaborar estrechamente con humanos, desde residencias de ancianos hasta almacenes y fábricas, la necesidad de un robot más receptivo y facialmente realista es cada vez más urgente.

Interesados desde hace tiempo en las interacciones entre robots y humanos, los investigadores del Creative Machines Lab de Columbia Engineering llevan cinco años trabajando en la creación de EVA, un nuevo robot autónomo con un rostro dulce y expresivo que responde para adaptarse a las expresiones de los humanos. La investigación se presentará en la conferencia ICRA el 30 de mayo de 2021, y los planos del robot son de código abierto en Hardware-X.

Un robot súper expresivo

«La idea de EVA surgió hace unos años, cuando mis estudiantes y yo empezamos a darnos cuenta de que los robots de nuestro laboratorio nos devolvían la mirada a través de ojos saltones de plástico», explica Hod Lipson, catedrático de Innovación James y Sally Scapa (Ingeniería Mecánica) y director del Laboratorio de Máquinas Creativas.

Lipson observó una tendencia similar en la tienda de comestibles, donde se encontró con robots reponedores que llevaban insignias con su nombre y, en un caso, estaban ataviados con un acogedor gorro tejido a mano. «La gente parecía humanizar a sus colegas robóticos poniéndoles ojos, una identidad o un nombre», dijo. «Esto nos hizo preguntarnos, si los ojos y la ropa funcionan, ¿por qué no hacer un robot que tenga un rostro humano súper expresivo y receptivo?».

Aunque parezca sencillo, crear un rostro robótico convincente ha sido un reto formidable para los expertos. Durante décadas, las partes del cuerpo de los robots han sido de metal o plástico duro, materiales demasiado rígidos para fluir y moverse como lo hace el tejido humano. El hardware robótico ha sido igualmente tosco y difícil de trabajar: los circuitos, sensores y motores son pesados, consumen mucha energía y son voluminosos.

La primera fase del proyecto comenzó en el laboratorio de Lipson hace varios años, cuando el estudiante universitario Zanwar Faraj dirigió un equipo de estudiantes para construir la «maquinaria» física del robot.

«El mayor reto a la hora de crear el EVA fue diseñar un sistema lo suficientemente compacto como para caber dentro de los confines de un cráneo humano y, al mismo tiempo, lo suficientemente funcional como para producir una amplia gama de expresiones faciales», señaló Faraj.

Para superar este reto, el equipo recurrió en gran medida a la impresión 3D para fabricar piezas con formas complejas que se integraran sin problemas y de forma eficiente en el cráneo de EVA. Después de semanas de tirar de los cables para hacer que EVA sonriera, frunciera el ceño o se mostrara molesto, el equipo se dio cuenta de que la cara azul e incorpórea de EVA podía provocar respuestas emocionales en sus compañeros de laboratorio. «Un día estaba ocupándome de mis asuntos cuando EVA me dedicó una gran sonrisa amistosa», recuerda Lipson. «Sabía que era algo puramente mecánico, pero me encontré devolviendo la sonrisa por reflejo».

Una vez que el equipo estuvo satisfecho con la «mecánica» de EVA, empezaron a abordar la segunda gran fase del proyecto: programar la inteligencia artificial que guiaría los movimientos faciales de EVA. Aunque hace años que se utilizan robots animatrónicos reales en parques temáticos y estudios de cine, el equipo de Lipson hizo dos avances tecnológicos. EVA utiliza inteligencia artificial de aprendizaje profundo para «leer» y luego reflejar las expresiones de los rostros humanos cercanos. Y la capacidad de EVA para imitar una amplia gama de expresiones faciales humanas diferentes se aprende por ensayo y error a partir de la observación de vídeos de sí mismo.

Las actividades humanas más difíciles de automatizar son los movimientos físicos no repetitivos que tienen lugar en entornos sociales complicados. Boyuan Chen, estudiante de doctorado de Lipson que dirigió la fase de software del proyecto, se dio cuenta rápidamente de que los movimientos faciales de EVA eran un proceso demasiado complejo para ser gobernado por conjuntos de reglas predefinidas.

El robot devuelve la sonrisa

Para enseñar a EVA el aspecto de su propia cara, Chen y su equipo grabaron horas de imágenes de EVA haciendo una serie de caras al azar. A continuación, al igual que un ser humano que se ve a sí mismo en el Zoom, las redes neuronales internas de EVA aprendieron a emparejar el movimiento de los músculos con las secuencias de vídeo de su propia cara.

Ahora que EVA tenía una idea primitiva de cómo funcionaba su propia cara (lo que se conoce como «autoimagen»), utilizó una segunda red para emparejar su propia autoimagen con la imagen de un rostro humano captada por su cámara de vídeo. Tras varias mejoras e iteraciones, EVA adquirió la capacidad de leer los gestos de un rostro humano desde una cámara y responder reflejando la expresión facial de ese ser humano.

Los investigadores señalan que el EVA es un experimento de laboratorio y que la imitación por sí sola está muy lejos de las complejas formas de comunicación de los seres humanos mediante expresiones faciales. Pero estas tecnologías podrían tener algún día aplicaciones beneficiosas en el mundo real. Por ejemplo, los robots capaces de responder a una amplia variedad de lenguaje corporal humano serían útiles en lugares de trabajo, hospitales, escuelas y hogares.

«Hay un límite en cuanto a la capacidad de los seres humanos para interactuar emocionalmente con los chatbots basados en la nube o los altavoces inteligentes para el hogar», afirma Lipson. «Nuestros cerebros parecen responder bien a los robots que tienen algún tipo de presencia física reconocible».

Y añadió Chen: «Los robots se entremezclan en nuestras vidas de forma creciente, por lo que crear confianza entre humanos y máquinas es cada vez más importante.»

Fuente del estudio:

El estudio se titula «Smile Like You Mean It: Conduciendo la cara de un robot animatrónico con modelos aprendidos».

Los autores son: Boyuan Chen, Yuhang Hu, Lianfeng Li, Sara Cummings y Hod Lipson, de Ingeniería Mecánica e Informática, Columbia Engineering.

Te puede interesar

https://quo.eldiario.es/tecnologia/q2103681550/robot-humanoide-realista-con-inteligencia-artificial-llamadme-euclides/