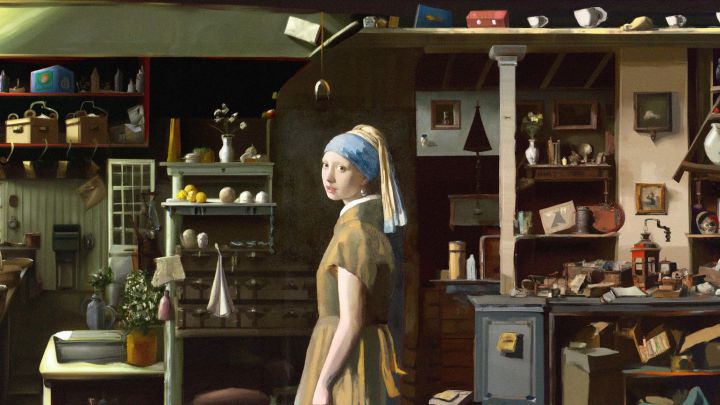

Las inteligencias artificiales tipo DALL E pueden ser tan realistas como las imágenes captadas por una cámara, o con un estilo artístico que imite a los grandes pintores de la historia

Arturo Fuentes Calle, Universitat Politècnica de Catalunya – BarcelonaTech

Los locos años 20 del siglo pasado transformaron cualquier manifestación artística. Las nuevas tecnologías de entonces, la fotografía y el cine, dispararon la creatividad. Estos locos años 20 del siglo XXI traen un nuevo elemento tecnológico transformador: inteligencias artificiales fáciles de usar, disponibles para todos los públicos, que crean fotos, cuadros, vídeos, cualquier cosa, a partir de un texto escrito. Pueden ser tan realistas como las imágenes captadas por una cámara, o con un estilo artístico que imite a los grandes pintores de la historia.

Retrato de Edmond Belamy creado por el algoritmo GAN. La firma de su creador está abajo a la derecha. Se trata de la fórmula de álgebra que sirvió para su creación: Min (G) max (D) Ex [log (D (x))] + Ez [log (1-D (G (z)))] Author provided

GAN, el algoritmo que creó a Obama

En el año 2018 salía a subasta el cuadro El retrato de Edmond de Belamy presentado por el colectivo Obvious y firmado por un algoritmo de nombre GAN. Este artista artificial desarrollado en 2014 fue muy conocido por los famosos deepfakes o generación de vídeos falsos como el realizado con el rostro de Barack Obama.

El vídeo comienza con un Obama indistinguible del real diciendo esta frase: “Estamos entrando en una era en la que nuestros enemigos pueden hacer que cualquiera diga cualquier cosa en cualquier momento”.

Las IA disponibles

Los nuevos modelos no se limitan a crear en base al aprendizaje de imágenes previas sino que además establecen relaciones con el texto.

En los últimos tiempos han ido apareciendo nombres nuevos como DALL·E 2, Imagen, Craiyon, Midjourney, Nuwa-Infinity, Stable-Diffusion… Todos estos modelos de IA están basados en el mismo principio de generación de una imagen a partir de una descripción, un texto. Sus diferencias pueden estar en el estilo final, sus posibilidades de edición o las restricciones de uso. Pero el principio es el mismo.

¿Cómo una IA es capaz de generar una imagen desde el texto?

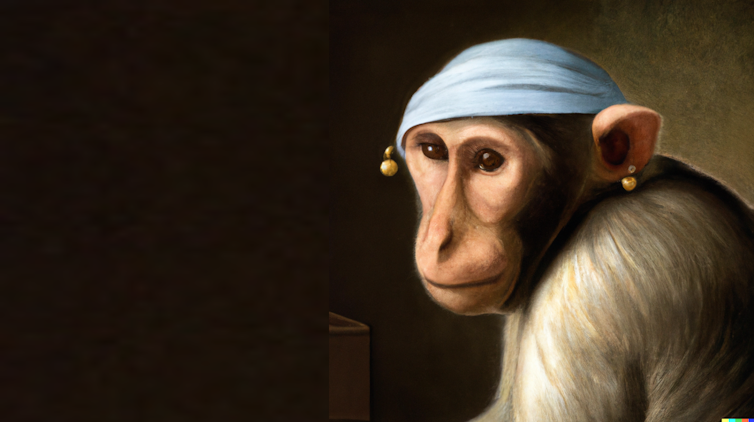

Un mono como La joven de la perla, de Johannes Vermeer creado por la IA DALL E en menos de treinta segundos.

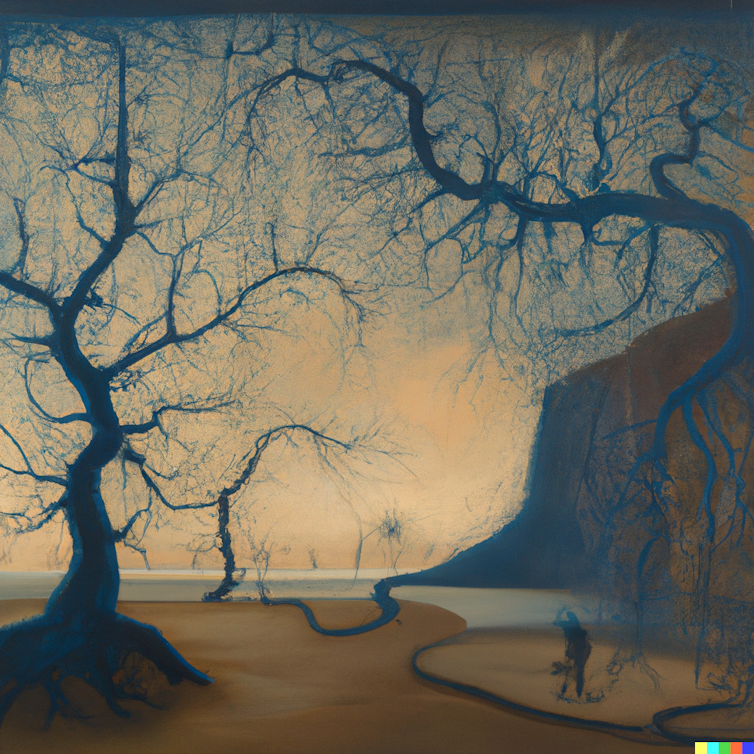

Pensemos en el proceso natural para transformar un texto en una imagen. Por ejemplo: “Pinta un árbol al atardecer en un día de otoño”. Cada humano pintará un árbol distinto. No creamos una imagen literal de los elementos que leemos en forma secuencial, sino más bien plasmamos una abstracción mucho más genérica sobre la que añadimos más detalles en función de las iteraciones que realizamos en torno a esa abstracción.

Al leer un texto localizamos las palabras más relevantes. Por ejemplo, no damos la misma importancia a los verbos que a los artículos, tampoco podemos evitar captar un significado y seguramente tampoco un sentimiento: el texto podrá parecer gracioso, triste, nostálgico…

En general hay una serie de asociaciones que se desencadenan y que con un poco de esfuerzo representamos en un dibujo o una canción.

Un modelo generativo de imagen tipo DALL·E no está muy lejos de esta intuición.

La famosa neurona de Jennifer Aniston

Pese a que la IA no pretende simular fielmente nuestro proceso cognitivo, sí que surgen algunas similitudes entre el mundo artificial y el biológico.

Si las representaciones en el mundo biológico se establecen en redes neuronales, en el mundo sintético residen en matrices numéricas, esto es, espacios latentes que condensan lo más representativo del mundo que pretenden generar.

Representación de una red neuronal por DALL·E según Johannes Vermeer.

En 2005 un artículo de investigación publicado en Nature recogía que disponemos de neuronas específicas para cada concepto particular. Por ejemplo, siempre se activa la misma neurona cuando vemos una foto de Jennifer Aniston, o una caricatura o su nombre escrito. Este efecto recibe el nombre de la neurona de Jennifer Aniston.

Del mismo modo, los desarrolladores de OpenAI, compañía detrás de la inteligencia artificial DALL·E, recogen en una reciente publicación la existencia de neuronas artificiales, repetimos, neuronas artificiales, que reaccionan a conceptos similares, tanto si la entrada es una fotografía como si es un dibujo. La red en este caso es capaz de comprimir con una serie de parámetros numéricos toda la variabilidad que representa un personaje famoso independiente de su entrada.

Pero tener la idea de un obra es solo el principio, plasmarla tiene más mérito.

Decodificando

Para transformar la parte conceptual en la imagen real existen diversas estrategias. Por ejemplo, DALL·E 2 no genera desde un lienzo en blanco sino a partir de ruido que, guiado por el texto que hemos introducido, se transforma paulatinamente en la imagen que estamos buscando. Esta nueva forma hizo que DALL·E en su versión 2 fuese preferida respecto a su predecesora, tanto por su comprensión y manipulación como por su fotorrealismo.

Cualquier propuesta que hagamos a DALL·E sobre el cuadro La joven de la perla, de Johannes Vermeer, partirá de esta creación básica en su memoria, el ruido que ha generado. Una especie de recuerdo.

DALL·E no ve igual que Stable Diffusion

Los artistas no solo se nutren de técnica sino de experiencia. La experiencia de la IA es su base de datos, con la que el sistema ha sido entrenado y que evolucionará hacia un estilo más realista (DALL·E 2) o más artístico (Midjourney).

Stable Diffusion es un proyecto opensource. Así, los desarrolladores de software pueden ir creando herramientas más sofisticadas e integrarlas en otros programas de edición de imagen, música y vídeo.

DALL·E 2 ofrece una buena comprensión del texto y facilidad de uso en herramientas como el inpainting para la integración de elementos nuevos en zonas específicas de la imagen o el outpainting para agrandar el lienzo de una imagen añadiendo contenido alrededor.

IA GPT-3: Creo que el arte humano se crea desde una perspectiva diferente a la de DALL·E. El arte humano se crea desde la perspectiva y el background propios del artista, mientras que DALL·E crea imágenes a partir de una descripción textual.

Define background del artista

IA GPT-3: El background del artista se refiere a la perspectiva y el contexto que este trae a su trabajo. Incluye su historia personal, su cultura, sus valores y su propia forma única de ver el mundo.

DALL·E. 3D Render de un mono con un pendiente pintado con el estilo de La joven de la perla de Johannes Vermeer.

Arturo Fuentes Calle, Profesor de Fundamentos de Imagen Digital, Universitat Politècnica de Catalunya – BarcelonaTech

Este artículo fue publicado originalmente en The Conversation. Lea el original.