En el futuro, los robots ayudarán a los humanos en las tareas del hogar; sin embargo, resultarán peligrosos para las personas, ya que podrían causarles heridas al utilizar ciertas herramientas.»Esta advertencia la hacía un equipo de investigadores del Instituto de Robótica y Mecatrónica de la Agencia Aeroespacial de Alemania en la Conferencia Internacional de Robótica y Automatización que se celebró en mayo en Alaska. Estos ingenieros programaron un brazo robótico para que trabajara utilizando varios instrumentos puntiagudos junto a materiales que imitaban el tejido humano. ¿El resultado? El robot realizó varias mutilaciones sin darse cuenta, por lo que los expertos auguran la necesidad de diseñar sistemas de detección que les permitan ser cuidadosos. Pero ¿cómo?

Prevenir para no curar

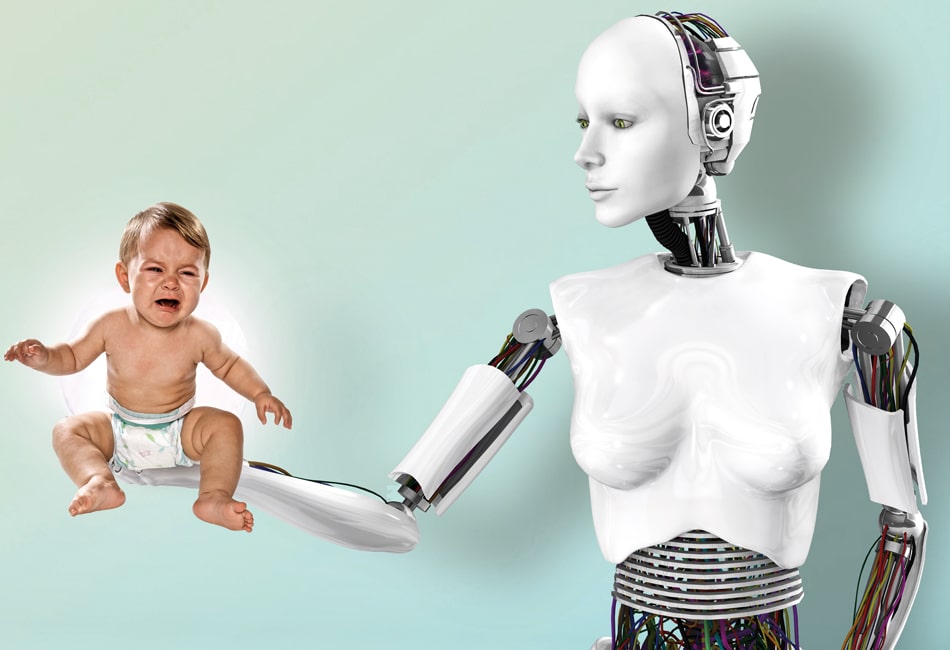

“Bajo mi punto de vista lo ideal es introducir en nuestro entorno robots ya desarrollados pensando en salvaguardar nuestra seguridad y no crear robots poco seguros y resolver los problemas después. Así, en vez de permitir que el robot manipule libremente una herramienta afilada e introducir una medida de seguridad que evite que nos haga daño a posteriori, podemos diseñar un robot que no cree este riesgo en primera instancia, metiendo estos utensilios afilados en un recipiente cerrado o dotándolo de otras herramientas más seguras”, afirma Bilge Mutlu, experto en interacción entre robots y ser humano de la Universidad de Wisconsin-Madison (EEUU). También Wandel Wallach, experto en Ética de la Universidad de Yale, y Colin Allen, historiador de la Universidad de Indiana, proponen en su obra La moral de las máquinas, enseñar a los robots lo que está bien y lo que está mal seis estrategias en esta línea: “No dejar en manos de máquinas que puedan llevar a cabo acciones imprevisibles decisiones de alto riesgo; no darles armas; programar robots con principios; educarlos como si fueran niños para que aprendan de “forma natural” a distinguir entre el bien y el mal; y por último, hacer robots con emociones elevadas, como la empatía”.

En definitiva se trataría de que estas máquinas tuvieran creencias como “no hagas a los demás lo que no te gustaría que te hicieran a ti”, y unos valores similares a los que mueven la ética humana. Como asegura John Storrs Hall, autor de Más allá de la Inteligencia Artificial, creación de la conciencia de una máquina: “Si construyes inteligencia artificial, pero no piensas en su sentido moral o creas una sensación consciente de arrepentimiento cuando haga algo mal, estarás creando un psicópata”. Pero según los expertos, las leyes que describía Asimov en su obra Yo, robot resultarían insuficientes con los robots actuales. Chien Hsun Chen y Weng Yueh-Hsuan, autores de un artículo al respecto publicado en la Revista Internacional de Robótica Social, creen en la necesidad de crear una “roboética” que describa de forma explícita la forma en que se deberá castigar a un robot, y regular así posibles conflictos en el futuro. Según Chen, en 2030 ya se podrá hablar de una sociedad en la que cohabiten robots y humanos.

Futuro inminente

No en balde, actualmente los aspiradores de iRobot, entre los que está el archifamoso Roomba, limpian ya 5 millones de hogares en todo el mundo. Sin embargo, según sus creadores, estos robots son muy seguros actualmente. “Un coche videocontrolado por un niño pequeño es más peligroso que un Roomba”, afirma Colin Angle, uno de los creadores de iRobot. Aunque el riesgo en este caso no consiste en que te cercenen un pie, sino en que te encariñes en exceso.

Iván Bermejo, director de Iberobotics, en cuya tienda online se puede adquirir todo tipo de robots domésticos y profesionales, asegura: “Cuando algo se mueve, los seres humanos tenemos tendencia a otorgarle vida y proyectar en él nuestro comportamiento, tanto el bueno como el malo. Pero un aspirador no tiene voluntad”.

De hecho, en Estados Unidos hay estudios documentados, como el publicado por la Universidad Carnegie Mellon, en los que se ve cómo los propietarios de robots aspiradores les ponen nombre, los saludan cortésmente al cruzárselos por un pasillo, e incluso los visten como si fueran mascotas. Y por si esto fuera poco, Bermejo comenta: “Hay clientes que nos llaman y nos dicen que su robot aspirador se ha tirado por la escalera”.

Y esto, con una especie de platillo volante “aspirapelusas”; así que ¿qué sucederá cuando sean humanoides tan parecidos a nosotros que nos cueste distinguirlos? “Estamos lejos de conseguir robots humanoides como los que vemos en las películas. Aunque el avance es exponencial y cada robot aspirador que se vende hace que este mercado se expanda. Estamos más o menos como la informática en los 70, aún hace falta que se produzca un salto tecnológico que nos permita crear un robot que comprenda su entorno y actúe en consecuencia”, comenta Bermejo. Para cuando llegue ese momento, deberemos mejorar algunas cosas.

Precisamente, en el último Simposio sobre Robótica Humanoide, celebrado en Londres en marzo, se hizo hincapié en los flecos técnicos que hay que mejorar para un futuro sin peligros. El primero es la comunicación.

¿Malentendidos?

El reto es crear robots capaces de entendernos, e incluso de aprender nuestros modales. Según Bilge Mutlu: “El éxito de la comunicación entre robots y humanos depende en gran medida de la evolución de la inteligencia artificial, en particular del reconocimiento de voz, y de hallar un lenguaje común”.

En un estudio realizado por el propio Mutlu sobre la relación de TUG, un robot dispensador de medicinas en un hospital, y las personas con las que se relacionaba (personal de hospital, enfermos…) concluyó que, como esperamos que los robots sigan las normas sociales, cuando hacen algo “incorrecto”, nos sentimos atacados. Por eso “debemos determinar qué normas y comportamientos serán apropiados en el entorno en el que van a convivir y facilitárselos”, asegura Mutlu.

Por otra parte, un equipo de la Universidad de Bristol está desarrollando un sistema, CHRIS (Cooperative Human Robot Interaction Systems), que es una mezcla entre lenguaje verbal y de gestos, con el que podremos saber, por ejemplo, que nuestro robot pinche de cocina quiere que le pasemos una sartén por el gesto que haga con sus ojos sobre el objeto en cuestión. Además, según Chris Melhuish, del Laboratorio de Robótica de Bristol: “Deberíamos añadir la perplejidad al repertorio de sus expresiones faciales, para saber cuándo no han entendido una orden”. La otra gran laguna técnica que mejorará nuestra seguridad en el trato con robots es el desarrollo de un tacto sintético adecuado.

En las distancias cortas

La piel sintética no es solo un tema estético. La mejora de su sentido del tacto evitará que ejerzan demasiada presión al coger a un niño, por ejemplo, y prevendrá que le hieran accidentalmente. En mayo, un equipo del Instituto Italiano de Tecnología (IIT) en Génova envió a laboratorios de toda Europa las primeras unidades de su piel sensible al tacto, diseñada para su robot humanoide iCub. La piel del IIT contiene sensores de presión flexibles que ponen al robot en “con-tacto” con el resto del mundo. Según Giorgio Metta del IIT: “Una buena piel artificial debe ser resistente y capaz de detectar pequeños roces”. La desarrollada por ellos “siente” hasta un gramo en cada táxel (píxel táctil), y pronto podrá identificar la fragilidad del objeto que toque, para adecuar su presión al extremo. Y hablando de piel, un área de la robótica en auge y muy controvertida es la de los juguetes sexuales robóticos.

Acércate más

Según The Economist: “Las relaciones sexuales con robots serán un negocio en los próximos cinco años”. Y es que, si existe el sexo con muñecas inflables, cómo no con humanoides como Roxxxy, la muñeca de TrueCompanion cuyo calor corporal imita al nuestro, puede cambiar de personalidad y hasta simular los flujos reales. Puede parecer una diversión inofensiva, pero sin regulación, es cuestión de tiempo que aparezcan usos de estos juguetes que nos lleven a terrenos tan peligrosos como la pedofilia. Lo que plantea que, además de un peligro físico, los robots también podrían ser dañinos para los humanos de una manera indirecta, al sacar a la luz nuestras miserias y obligarnos a defendernos de nosotros mismos.

¡Qué paradoja!

Redacción QUO