En su primera hora de vida, un bebé ya mira los rostros durante más tiempo que cualquier otro objeto. Llegamos sabiendo que ese será el conjunto de rasgos por el que mejor nos relacionaremos con nuestros semejantes. Nos ayudará a distinguirlos y nos lanzará pistas sobre cómo se sienten. Un tesoro de información único, casi siempre expuesto y, por lo visto, infrautilizado hasta hace unas décadas. Porque solo nos servía de tarjeta de visita cuando otro humano se paraba a analizarlo, identificarlo o probaba a traducir nuestras emociones.

Hasta que en 1960 Woodrow Bledsoe –pionero de la inteligencia artificial– intentó enseñar a una máquina a reconocer la fotografía de alguien entre las de muchos otros a partir de una clasificación de características faciales. Cincuenta años más tarde, Facebook empezaba a enmarcar solo las cabezas en las fotos de sus usuarios con la pregunta: ¿quieres etiquetar a esta persona? La gran revolución estaba en marcha.

El empujón de las redes sociales

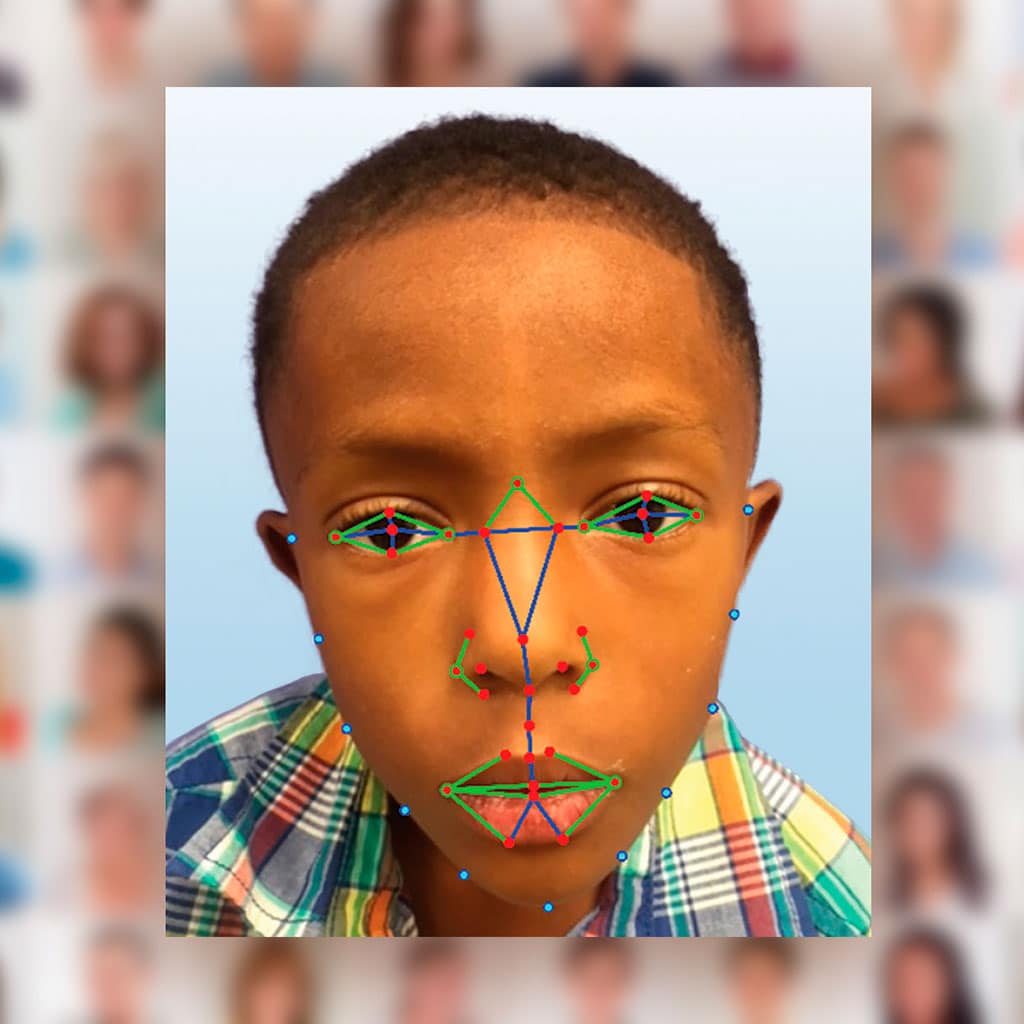

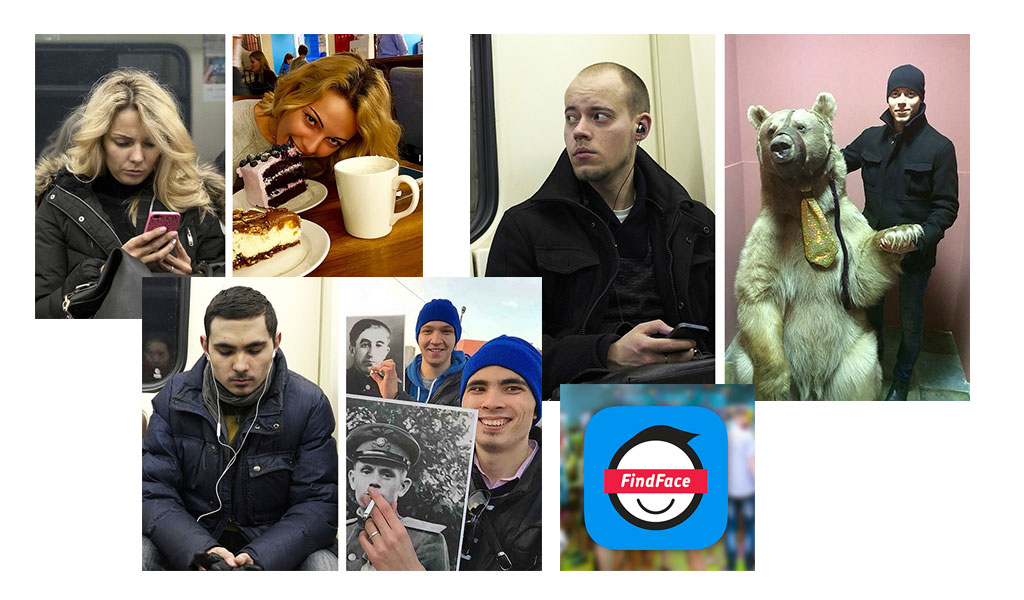

El nuevo juguete de la red social certificaba la madurez tecnológica para aislar automáticamente el rostro de alguien en imágenes sin especial calidad. Y su aceptación masiva –a pesar de las numerosas voces preocupadas por la privacidad de los usuarios– proporcionó una base de datos sin precedentes. Rostros asociados a nombres, sexo, localización y la plétora de detalles que vertemos en nuestros perfiles. Hoy subimos y etiquetamos 350 millones de fotos al día. Así ayudamos a los auténticos impulsores del reconocimiento facial. “En 2014 estas tecnologías experimentaron un cambio muy importante con la introducción de las técnicas de deep learning. Hasta entonces, el ingeniero le decía manualmente al sistema: la mejor característica para buscar a una persona es la distancia entre los ojos, o entre la nariz y la boca, por ejemplo. Y esto se hacía con unos bancos de imágenes muy pequeños”, recuerda Francesc Tarrés, profesor de Comunicaciones Audiovisuales en la Universidad Politécnica de Cataluña (Barcelona). Pero los millones y millones de imágenes en Facebook y Google permitieron crear logaritmos que aprendieran solos a base de comparar rasgos, la mejor forma de reconocer un rostro.

“En sus primeros artículos, ambas empresas tuvieron niveles de éxito del 95 %, es decir, lo que se considera que un humano puede hacer”, según Tarrés. Hicieron públicos sus modelos y provocaron un crecimiento exponencial en el sector. Con sus avances se entrenaban tecnologías que imitan el funcionamiento de las redes neuronales de nuestro cerebro. Cada una para su fin particular.

Los usos se han diversificado a una velocidad que deja sin resuello a los analistas con sus consecuencias. Porque el gran tema asociado a los avances en estas tecnologías es el derecho a la privacidad.

Sobre esa relación pretendían alertar los investigadores de la Universidad de Stanford (EE. UU.) Michal Kosinski y Yilun Wang cuando tomaron 35.000 fotos de una web de contactos cuyos usuarios especificaban su orientación sexual. Entrenaron con ellas a un algoritmo y comprobaron hasta qué punto acertaba esa característica en retratos elegidos al azar. El resultado: un 81 % en los hombres y el 71 % en mujeres, más alto que en las pruebas con humanos: el 61 % y el 54 % respectivamente. En una nota de su estudio, los autores aclaraban: “Nosotros no hemos construido una herramienta que invada la privacidad. Hemos estudiado las tecnologías existentes, que ya usan muchísimas empresas y Gobiernos, para ver si suponen un riesgo a la privacidad de los individuos LGBTQ. Nos aterrorizó ver que sí lo suponen”.

Comportamiento y cáracter

En el ámbito empresarial, el análisis de caras se está abriendo paso en los procesos de selección de personal. Con el programa HireVue la compañía pide a cada candidato a un puesto que grabe un vídeo respondiendo a una serie de preguntas. El producto analiza en él el tono, léxico, gestos y lenguaje corporal de todos los aspirantes y los compara con los de los mejores empleados. Establece así un ranking para que en personal empiecen por aquellos con más probabilidades.

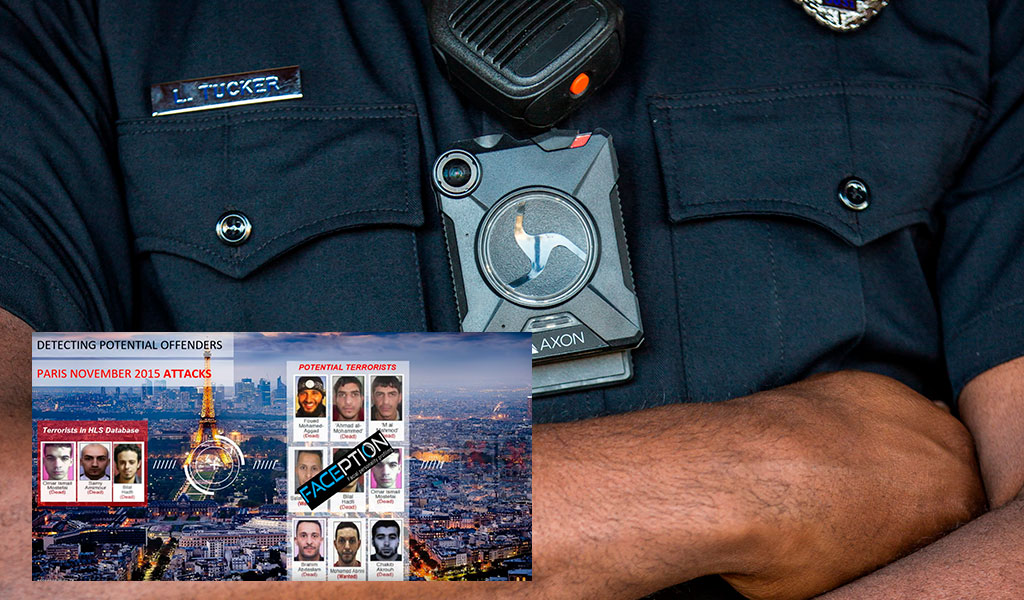

Aún más riesgo suponen empresas como la israelí Faception, que asegura que sus creaciones son capaces de detectar la propensión a la pederastia o al terrorismo de un individuo solo por su retrato. La base, alegan, está en que los genes influyen tanto en la personalidad como en la escultura del rostro. Mira la segunda y descifrarás la primera. Un discurso que magnifican sin base científica ciertos descubrimientos de coincidencia en el desarrollo de rasgos faciales y fenómenos más amplios, como enfermedades genéticas o condiciones psiquiátricas.

Federico Sukno colabora desde el Departamento de Tecnologías de la Información y las Comunicaciones de la Universidad Pompeu Fabra (Barcelona) en proyectos que utilizan el reconocimento facial en estudios sobre la esquizofrenia: “Se han encontrado diferencias en las geometrías faciales de pacientes con esquizofrenia contra controles, pero se trata de variaciones muy sutiles invisibles al ojo humano”, explica. Los factores que las provocan pueden también intervenir en la enfermedad. Sin embargo,

no se usan para establecer diagnósticos, porque “el que los pacientes con esquizofrenia tengan cierta asimetría no implica que esa asimetría sea un signo de esquizofrenia. Hay que tenerlo en cuenta porque se puede rozar la estimagtización”. La investigación clínica pretende utilizar esas variaciones solo como guía para profundizar en un trastorno psiquiátrico tan complejo.

¿Llegamos a ‘Minority Report’?

Otra línea de trabajo de Sukno es el Proyecto Kristina de la Unión Europea “para crear un avatar interlocutor en el sistema de asistencia sanitaria”. Con tareas como la recepción de personas con barreras lingüísticas y culturales, como migrantes que acuden al sistema sanitario y mayores. Para hacerlas viables, la máquina que será Kristina deberá interpretar las intenciones y sentimientos de sus interlocutores. Y dar expresión humana a su discurso.

El reconocimiento facial resulta clave en ambos objetivos. Incluso puede detectar señales fisiológicas inapreciables a simple vista, “como el constante cambio de color del rostro, debido a la irrigación sanguínea. Se ha demostrado que podemos captar

el latido del corazón de una persona mediante la cara”, explica el investigador.

También si lo que está viendo la aburre, asusta o entusiasma, una faceta valiosísima en los cursos online, el marketing o o la conducción. Ya existen paneles publicitarios dotados de sensores que reconocen en tu semblante tu sexo y edad y activan las ofertas apropiadas, pero se está trabajando en acercarnos aún más a los anuncios parlantes de Minority Report: si nos asocian a nuestro nombre, podrán utilizar nuestro comportamiento previo como consumidores para ajustar más sus propuestas a nuestro gusto personal. Y a nuestros sentimientos.

Disney desarrolla junto al Instituto de Tecnología de California (Caltech) un software para analizar la reacción del público. Aseguran que, tras observar a alguien en los primeros 10 minutos, puede predecir cuándo reirá durante el resto de la película. Más adelante analizarán otras emociones, como el miedo y la tristeza. Y pronto tendremos guiones programados para provocar sonrisas y lágrimas en momentos cronometrados.

De igual modo, los fabricantes de coches recurren al reconocimiento facial para proteger a los conductores o seducirles con tratamiento VIP. PSA, Peugeot, Citroën o BMW buscan localizar síntomas de cansancio o aburrimiento para evitar accidentes, y el concept car Chrysler Portal te identifica y adapta para ti el modo de conducción, la selección de música e incluso la altura del asiento. Lo de abrir el coche por la cara parece ser cuestión de tiempo.

Asalto a la aduana

Sin embargo, abrir una cuenta con un selfie y una videollamada es ya una realidad en el Alta Automática de BBVA. Los clientes de Arquia Bank operan en sus cuentas online identificándose con su rostro y el iPhone X de Apple acaba de desembarcar haciendo gala de la seguridad de su tecnología FaceID.

Te hará hablar para asegurarse de que no la burlas con una foto, un vídeo o una réplica impresa en 3D.

En España encontramos quioscos que nos hacen una foto y la comparan con los datos codificados en nuestro pasaporte electrónico en los aeropuertos de Girona, Alicante, Madrid, Palma de Mallorca, Málaga y Barcelona, el puerto de Algeciras y el paso entre Gibraltar y La Línea de la Concepción. Esa forma de verificar nuestra identidad se extenderá muy pronto a más lugares con cuellos de botella debido a una enmienda al Tratado de Schengen. “Hasta el 7 de abril los controles a ciudadanos y sus familiares de países del tratado y asociados en las fronteras exteriores de ese espacio eran aleatorios. Desde entonces son obligatorios para todo el mundo”, aclara Isabel de Santos, jefe de Grupo Operativo en la Unidad Central de Fronteras de la Policía Nacional. Esta opción solo se utiliza en mayores de edad con pasaporte o DNI con chip electrónico. Según la inspectora, las imágenes no se archivan en ningún lado, aparecen en la pantalla de los agentes a cargo del puesto sin más información que la nacionalidad (ni nombre, ni edad, ni sexo) y solo hasta que llega el siguiente pasajero. Sí se almacenan los datos sobre la nacionalidad, número de viajeros y si el sistema los ha reconocido o no. La tasa de fallos ronda el 15 %. En esos casos, se recurre a un policía, que echa el tradicional vistazo a viajero y pasaporte.

Él se enfrentará también a un problema que hace resoplar a cualquier experto en reconocimiento: los gemelos. Una de ellos, la investigadora (y gemela) Cristina Conde, asegura que “estos sistemas a veces nos confundirán, igual que los humanos. Ellos no se cansan, trabajan de forma masiva sobre miles de imágenes a la vez, pero no superan nuestra fiabilidad”. Desde la Universidad Juan Carlos I trabaja en el Proyecto ABC for EU, que busca armonizar el reconocimiento facial en todas las fronteras europeas, ya que ahora cada país ha elegido su tecnología.

Algunos aeropuertos, como el de Amsterdam Schiphol, están instalándola para otros usos, como la sustitución de tarjetas de embarque. En EE. UU., las compañías JetBlue y Delta han unido ese uso con la verificación de identidad en colaboración con la autoridad de control fronterizo en pruebas piloto. Esta llegó a declarar que, si las aerolíneas decidieran quedarse con copias de las fotos, no se les podría impedir.

Estado de vigilancia

Estas acciones han alarmado a los grupos de defensa de derechos civiles, ya vigilantes ante la creciente aceptación del reconocimiento facial entre las fuerzas del orden.

El informe The Perpetual Line Up (la ronda de reconocimiento perpetua), de la Universidad de Georgetown, la ha analizado con conclusiones alarmantes: su aplicación no está regulada legalmente y, sin embargo, las redes incluyen los datos de 117 millones de ciudadanos. De las 52 agencias que admitieron emplearlo, solo una tenía permiso. Y un único departamento de policía había prohibido a sus agentes “rastrear con él a individuos involucrados en la expresión de sus ideas políticas, religiosas u otro aspecto protegido”. Los más vulnerables: los afroamericanos. Entre otras razones, por la llamada discriminación algorítmica. Estos algoritmos suelen equivocarse más con las personas de raza negra, aún no está claro si por una mayor vulnerabilidad a la iluminación deficiente o porque aprenden de las imágenes con que los entrenan. Y la mayoría de los bancos en EE. UU. son de blancos.

Estas alertas se disparan con el uso, ya activado en algunos países, del reconocimiento en las cámaras de vigilancia de las calles. Las autoridades de Boston lo usaron en conciertos, pero en 2013 lo retiraron “porque cruzaba una línea ética”. La revista online New Enquiry propone combatirlo anonimizándonos en lugares públicos. En su web se pueden descargar máscaras con los rostros de 130 ejecutivos de las principales corporaciones de biometría. “Como han elegido ganar dinero robándonos la cara a los demás, deberíamos resistirnos con un acto recíproco. Pero, al no asociar sus nombres a sus caras, hemos decidido garantizarles justo lo que la industria nos deniega a nosotros: anonimato”.