Una app marcará en un texto, de modo automático, las incongruencias, y otras señales que alerten de que estamos ante una noticia falsa

Miguel Ángel García Cumbreras, Universidad de Jaén y Estela Saquete Boro, Universidad de Alicante

Las noticias falsas o fake news fueron definidas por The New York Times como una “historia inventada con la intención de engañar, a menudo con un beneficio monetario como motivo”.

Su objetivo principal es manipular la opinión pública para influir en los comportamientos sociopolíticos o en los sistemas de creencias de las masas, y normalmente se generan por intereses ideológicos o económicos. Detectarlas es cada vez más una prioridad social, y la inteligencia artificial es la única herramienta que puede contener la invasión de bulos online.

En el proyecto Living-Lang, los grupos de investigación GPLSI (Universidad de Alicante) y SINAI (Universidad de Jaén), trabajamos en la detección automática de noticias falsas. Estamos desarrollando un sistema basado en inteligencia artificial que marcará en un texto, de modo automático mientras se está leyendo, las incongruencias, y otras señales que alerten de que la información no es confiable. Hemos probado el sistema de detección en noticias sobre la covid-19.

Defendernos en la era de la posverdad

Las noticias falsas son el alimento de la “posverdad” en la que vivimos. Posverdad, escogida como palabra del año 2016 por el diccionario Oxford, se refiere a un fenómeno de distorsión en el que los hechos objetivos influyen menos en la formación de la opinión pública que las apelaciones a la emoción y a las creencias personales.

Hoy en día el término tiene una aplicación mucho más amplia en el proceso de generación de noticias, donde los “hechos alternativos” sustituyen a los hechos reales, y los sentimientos tienen más peso que las pruebas.

La proliferación de noticias falsas se ha visto facilitada por el crecimiento de blogs personales y de medios sociales como Twitter, Facebook o WhatsApp. Cualquiera puede ser un transmisor de información y la comprobación de los hechos es menos prioritaria que compartir noticias que puedan ser virales.

Actualmente, la información se consume mayoritariamente en línea. Investigadores del MIT han realizado un estudio que demuestra el inquietante poder de las noticias falsas, que se difunden mucho más lejos, más rápido y más ampliamente que las reales.

Un problema adicional es que las noticias falsas están estructuradas y redactadas de forma que resulta difícil distinguir entre lo que es verdadero y lo que es falso. Detectar y atajar las noticias falsas de forma rápida y eficaz es crucial, ya que una vez que la información falsa se difunde y permea en la sociedad, resulta difícil de refutar.

Esta situación de información falsa se agrava en tiempos de emergencia, como durante la pandemia mundial que estamos sufriendo por la covid-19. Según la IFCN durante la pandemia comprobaron más de 6 000 bulos que se propagaron por todo el mundo.

El número de bulos está alcanzando tal nivel de viralización que requiere de la aplicación de técnicas automáticas que permitan detectar las noticias falsas antes de que se difundan masivamente.

Detectar la información no confiable

Las técnicas de inteligencia artificial de forma general y de procesamiento del lenguaje natural de forma concreta toman un especial protagonismo para mejorar y acelerar el proceso de detección. Tecnologías como el aprendizaje automático o aprendizaje profundo hacen posible detectar características en la información que la hacen no confiable. Y todo esto trabajando entre millones de datos.

Las tecnologías para verificar hechos trabajan de distintas maneras. Hay enfoques de referencia, que buscan un hecho en alguna fuente de referencia; de aprendizaje automático, que intentan aprender señales de probabilidad de veracidad; y contextuales, que evalúan la probabilidad de veracidad en función del tiempo que sobreviven las historias. Lo ideal sería combinar estos tres tipos.

Debido a la complejidad de detectar un bulo, la tarea no se aborda como un todo, sino como pequeñas subtareas relacionadas que deberían acabar integrándose en un único sistema global de detección.

Errores en la estructura y en el contenido

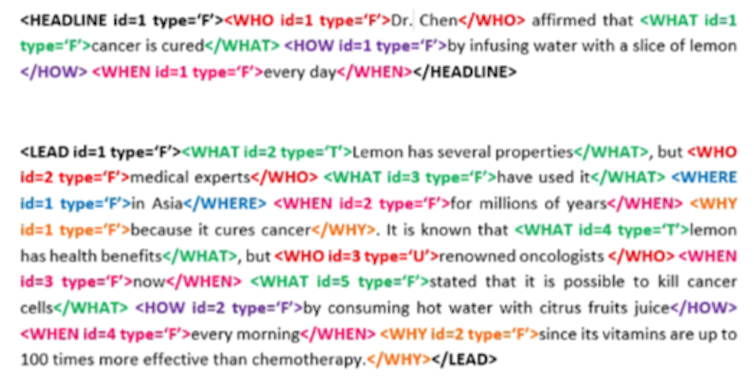

Hemos diseñado un sistema que comprueba la noticia en dos niveles, analiza su estructura y su contenido. Para analizar su estructura, revisamos si cumple las normas de periodismo clásicas: la regla de las 5W1H y la pirámide invertida (un concepto de estructura textual relacionado con el periodismo).

La regla de las 5W y una H se refiere a que cualquier texto periodístico ha de responder a estas preguntas: What = Qué, Where = Dónde, When = Cuándo, How = Cómo, Who = Quién y Why = Por qué. Esta teoría es un método efectivo que se adaptó en los distintos medios de comunicación.

Además, la pirámide invertida consiste en jerarquizar la información, contando en el primer párrafo lo más relevante. La inteligencia artificial detecta si el texto que analiza sigue esta regla y, si no lo hace, la información que contiene puede no ser confiable.

Respecto al contenido de la noticia, dividimos las partes de una noticia (título, subtítulo, etc), y utilizamos un sistema de verificación de hechos (fact checking) para comprobar los hechos factuales que se indican con bases de conocimiento. También extraemos diversas características lingüísticas de forma automática.

¿Cómo hemos probado el sistema?

Para probar la efectividad de nuestro sistema hemos generado un conjunto de datos (dataset) de noticias relativas a la covid-19 que contiene noticias reales y falsas. Un ejemplo de noticia publicada y que es falsa es la siguiente:

“El covid-19 no es un virus, es un exosoma. Es la contaminación lo que debilita el sistema inmune, y, como consecuencia, la gente muere por varias causas, incluso la gripe estacional, y todas las muertes se etiquetan como coronavirus. Es una estafa. Y empeorará, cuando la 5G esté plenamente desplegada en la Tierra y el espacio, van a morir miles de millones de personas y se culpará a otra pandemia. No es un virus, es un arma electromagnética.”

En nuestro trabajo de investigación hemos etiquetado manualmente un conjunto de noticias, en cuanto a estructura, contenido y veracidad.

Haciendo uso de algoritmos de aprendizaje automático y profundo, y usando como

entrada un dataset relativamente pequeño debido a la complejidad en la anotación, los resultados obtenidos han sido muy prometedores. Hemos obtenido un 75 % de acierto en la veracidad de una noticia partiendo de un texto plano extraído de internet. La investigación ha sido publicada recientemente en una revista de alto impacto internacional.

La siguiente imagen muestra un ejemplo del etiquetado que se realiza sobre un párrafo cualquiera:

Con los buenos resultados obtenidos, el siguiente paso es desarrollar una aplicación final que marque automáticamente el texto de una noticia mientras se lee y que alerte mediante una señal de partes de la noticia que puedan ser falsas, indicando la referencia con otros textos similares en los que se pueda contrastar su veracidad.

De esta forma tanto un usuario final como un periodista podrían utilizar esta información para tomar la decisión más conveniente sobre su veracidad.

Miguel Ángel García Cumbreras, Doctor en Ingeniería Informática. Subdirector de la Escuela Politécnica Superior de Jaén., Universidad de Jaén y Estela Saquete Boro, Titular Universidad Lenguajes y Sistemas Informáticos, Universidad de Alicante

Este artículo fue publicado originalmente en The Conversation. Lea el original.